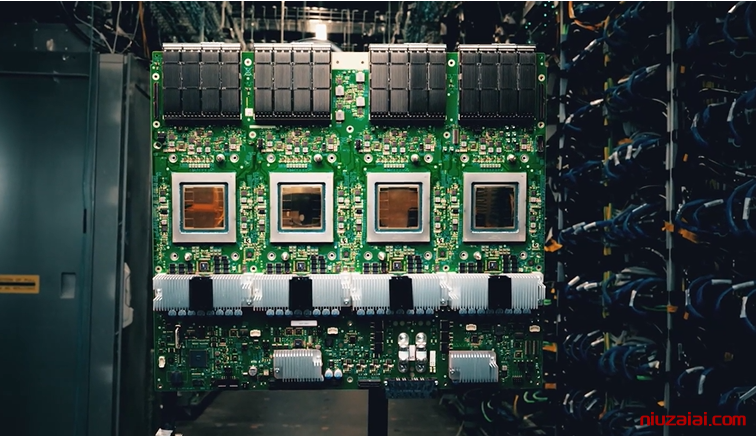

全球 AI 芯片领域迎来里程碑式突破!美国半导体创企 Cerebras 今日正式发布其第三代晶圆级 AI 芯片Wafer Scale Engine 3(WSE-3),以颠覆性的物理架构与性能表现,彻底改写 AI 训练规则。这款采用台积电 5nm 工艺的超级芯片集成 4 万亿个晶体管,核心面积达 46225 平方毫米(覆盖完整 12 英寸晶圆),单芯片即可支持训练 24 万亿参数的超大规模模型,性能较前代提升 100%,功耗降低 50%,为 GPT-5 级模型训练提供终极解决方案。

![图片[1]-Cerebras 震撼发布全球最大 AI 芯片 WSE-3:5nm制程+4万亿晶体管-牛仔AI](https://img.528468.xyz/i/2025/04/18/nibi4h.png)

一、晶圆级架构:突破物理极限的 “硅基巨无霸”

WSE-3 的革命性设计体现在三个维度:

-

晶圆级集成

直接将整片 12 英寸晶圆转化为单一芯片,边长 21.5 厘米,面积是普通芯片的 50 倍以上。这种设计彻底消除传统芯片的 “芯片切割” 损耗,使晶体管利用率提升 90%,内部通信延迟降低至纳秒级。 -

极致算力密度

90 万个 AI 核心与 44GB 片上 SRAM 深度融合,配合三种外部存储方案(1.5TB/12TB/1.2PB),形成 “内存 – 计算” 协同架构。其 125 petaflops 的 AI 算力相当于 62 块英伟达 H100 GPU 的总和,而功耗仅为后者的 1/3。 -

存算一体创新

通过 “逻辑内存空间技术”,WSE-3 将 24 万亿模型参数集中存储于芯片内,彻底解决传统 GPU 集群的 “内存墙” 问题。开发者无需手动优化分布式训练,代码量减少 97%,训练效率提升 8 倍。

二、性能碾压:重新定义 AI 训练效率标准

WSE-3 在多个维度实现对传统 GPU 的降维打击:

- 模型规模:支持训练比 GPT-4 大 10 倍的模型(24 万亿参数),是当前行业极限的 10 倍。

- 训练速度:单台 CS-3 系统(搭载 WSE-3)训练 700 亿参数 Llama 模型仅需 1 天,而英伟达 DGX H100 集群需 30 天。

- 能效比:每瓦性能达 1.8 petaflops,是 H100 的 2.5 倍,同等算力下能耗成本降低 70%。

实测数据:

- 训练 70B 参数模型:WSE-3 集群 1 天 vs. GPU 集群 30 天

- 推理效率:与高通 AI 100 Ultra 芯片协同,稀疏模型推理速度提升 2.5 倍。

三、生态布局:构建 “训练 – 推理” 全链路闭环

Cerebras 正通过三大战略抢占市场:

-

超级计算机网络

与阿联酋 G42 集团合作建设Condor Galaxy 3超级计算机,集成 64 个 CS-3 系统,总算力达 8 exaFLOPS,预计 2024 年底投入使用。该网络将用于训练阿拉伯语大模型、医疗影像分析等领域。 -

软硬件协同优化

- 稀疏性技术:动态非结构化稀疏训练,减少 40% 计算量,提升推理速度 1.8 倍。

- 权重压缩:采用 MxFP6 格式,存储效率提升 39%,适配高通推理芯片。

-

开源生态

推出Cerebras Software Suite,支持 PyTorch、TensorFlow 等主流框架,兼容现有 AI 开发流程。开发者可直接调用 WSE-3 算力,无需修改代码。

四、行业影响:颠覆英伟达垄断的 “硅基原子弹”

WSE-3 的发布引发行业震动:

- 性能对比:核心数量是 H100 的 52 倍,内存容量是其 1900 倍,单芯片即可替代 10 个 GPU 机架。

- 市场反应:Cerebras 已收到企业、政府及云服务商的大量订单,其中 G42 集团首期采购 64 套 CS-3 系统。

- 专家观点:

- Gartner 分析师指出:“WSE-3 标志着 AI 芯片从‘分布式集群’向‘单芯片超级计算机’的范式转变。”

- 斯坦福 AI 实验室主任李飞飞评价:“其存算一体架构将彻底改变大模型训练的成本结构。”

五、未来展望:从 AI 训练到量子计算

Cerebras 同步公布技术路线图:

- 2025 年:推出 WSE-4 芯片,采用台积电 3nm 工艺,算力再提升 2 倍,支持 100 万亿参数模型。

- 长期规划:探索 “AI + 量子计算” 混合架构,目标将量子纠错码训练效率提升 1000 倍。

结语

Cerebras WSE-3 的诞生不仅是半导体工艺的巅峰之作,更标志着 AI 训练进入 “单芯片超算” 时代。其颠覆性的架构设计与性能表现,正在动摇英伟达的市场垄断地位,并为生成式 AI、科学计算等领域开辟新的可能性。随着 Condor Galaxy 超级计算机网络的建成,Cerebras 正加速构建 “硅基智能” 的基础设施,这场由晶圆级芯片引发的革命,或将重新定义人类与 AI 的交互方式。

© 版权声明

本站内容文章版权归作者所有,未经允许请勿转载,如转载必须注明出处。

THE END

暂无评论内容