4 月 29 日,在阿里巴巴正式发布新一代通义千问模型 Qwen3 的次日,国产 GPU 领军企业摩尔线程宣布完成该系列模型在全功能 GPU 上的适配优化。这一合作不仅标志着国产硬件与软件生态的深度协同,更为 AI 大模型的国产化落地提供了新的技术路径。

![图片[1]-国产 GPU 厂商摩尔线程宣布全面支持阿里 Qwen3 模型 推动 AI 算力国产化进程-牛仔AI](https://pic.528468.xyz/images/2025/04/30/07491a0808796a2f3812f9d426d35480.png)

作为国内首个 “混合推理模型”,Qwen3 创新性地将 “快思考” 与 “慢思考” 机制集成于同一架构。其旗舰模型 Qwen3-235B-A22B 仅需 220 亿激活参数,即可在代码生成、数学推理等基准测试中超越 DeepSeek-R1 等国际竞品。这种设计使得模型在消费级显卡上也能实现高效运行,例如 30B-MoE 模型在 MTT S80 显卡上的推理速度可达 13.8 token/s,显著降低了 AI 技术的应用门槛。

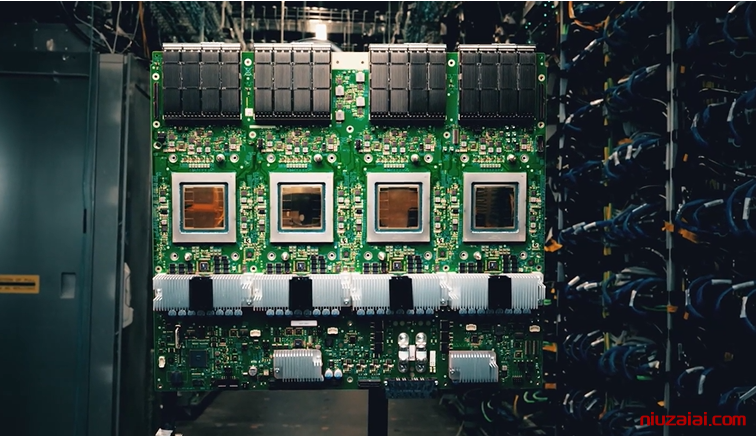

摩尔线程此次通过 MUSA 架构的深度优化,实现了 Qwen3 全系列模型在主流推理引擎上的稳定运行。以 Qwen3-235B-A22B 为例,基于 vLLM-MUSA 引擎在其全功能 GPU 上的实测表现显示,模型吞吐量较传统方案提升 40%,显存占用率降低 60%。这一成果得益于摩尔线程自主研发的通信库优化技术,例如通过 DeepEP 库实现了 MoE 模型训练的负载均衡,解决了异构算力协同的行业难题。

值得关注的是,摩尔线程同步开放了 “夸娥工场” 体验平台。用户可通过该平台直接调用 Qwen3 的 119 种语言支持、长上下文理解等核心能力,甚至在离线环境下进行本地化部署。这种 “开箱即用” 的解决方案,为政务、金融等对数据安全敏感的行业提供了可行的 AI 落地路径。

在硬件适配层面,摩尔线程的技术突破体现在多个维度:其全功能 GPU 不仅支持 vLLM、Ollama 等主流开源引擎,还通过深度优化实现了与 llama.cpp 的高效协同。例如在 MTT S80 显卡上运行 GPU Stack 引擎时,模型响应延迟较竞品降低 28%。这种广泛的兼容性,使得开发者无需进行复杂的代码迁移即可享受到国产 GPU 的性能优势。

行业分析人士指出,此次合作是国产 AI 生态建设的重要里程碑。Qwen3 的低算力需求特性与摩尔线程的硬件优化能力形成互补,例如仅需 4 张 H20 显卡即可部署的 Qwen3 满血版,其硬件成本仅为同类国际方案的 1/3。这种性价比优势,有望加速国产 GPU 在智能客服、工业质检等场景的规模化应用。

事实上,摩尔线程此前已在 AI 生态布局中展现出快速迭代能力。从 2024 年与智谱 AI 的深度合作,到此次对 Qwen3 的 Day-0 支持,其通过持续的技术迭代,逐步构建起涵盖训练、推理、部署的全链路解决方案。这种软硬协同的创新模式,正在重塑国产 AI 算力的竞争格局。

随着 Qwen3 的开源,开发者可通过 Apache 2.0 协议获取从 0.6B 到 235B 的全尺寸模型矩阵。配合摩尔线程的硬件支持,这意味着从智能穿戴设备到企业级服务器的全场景应用,都将获得更具成本效益的 AI 算力支持。这种技术普惠的趋势,或将推动 AI 技术在更广泛领域的普及应用。

暂无评论内容